IA et référencement web en 2025 : vers un nouvel équilibre entre algorithmes et humains

L’année 2025 marque un tournant silencieux mais profond : les moteurs de recherche ne se contentent plus de classer les pages, ils répondent directement.

Avec l’arrivée des AI Overviews de Google et l’essor du Generative Engine Optimization (GEO), le référencement entre dans une ère où l’intelligence artificielle décide quelles sources méritent d’être citées. Les règles du jeu changent. Les sites web doivent désormais convaincre deux publics : les humains, et les IA.

1. Google et la recherche conversationnelle : la fin du “tout clic”

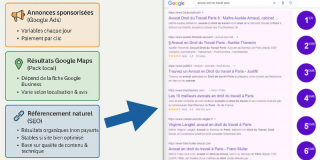

Depuis l’intégration des AI Overviews, Google affiche des résumés générés automatiquement en tête de ses résultats. L’utilisateur n’a plus besoin de cliquer sur un lien : l’IA lui donne directement la réponse, en citant une poignée de sites “jugés fiables”. Cette évolution confirme la montée des “zero-click searches”, déjà observée depuis plusieurs années.

L’impact est clair : le trafic organique diminue, surtout pour les sites de contenu généraliste ou d’actualités. Mais tout n’est pas perdu : les sites capables d’apporter des informations précises, sourcées et uniques continuent d’être valorisés.

2. Le retour du contenu “humain” : E-E-A-T puissance quatre

Les critères E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness) prennent une importance capitale. Google cherche des contenus crédibles, rédigés par des auteurs identifiés et liés à une expérience réelle. La bataille ne se joue plus sur le mot-clé mais sur la valeur du propos : avis d’expert, retours terrain, nuance, citations, preuve de vécu.

L’IA reste une compilatrice : elle a besoin de sources humaines solides. Le futur du SEO est moins dans la quantité que dans l’authenticité et la vérifiabilité.

3. GEO : le référencement pour moteurs génératifs

Le Generative Engine Optimization (GEO) représente la nouvelle frontière du SEO.

L’objectif : adapter son contenu non plus seulement à Google Search, mais aux IA génératives comme ChatGPT, Gemini ou Perplexity. Concrètement, cela implique : des contenus structurés en blocs courts et cohérents, faciles à citer ; une présentation claire des sources (liens, références, schémas) ; des FAQ ou Q&A intégrées ; des métadonnées enrichies (schema.org, JSON-LD) permettant aux IA de comprendre la hiérarchie des informations.

4. L’IA, un outil d’optimisation, pas une solution miracle

L’IA transforme aussi la manière de produire et d’analyser le contenu.

Des outils peuvent accélérer la recherche de mots-clés, proposer des plans ou détecter des failles techniques. Mais le risque est grand de tomber dans le contenu standardisé, sans âme ni contexte.

L’enjeu est donc d’hybrider : laisser l’IA proposer, garder la main sur le ton, la véracité et la profondeur. Les sites qui réussissent mêlent vitesse et discernement, pas quantité.

5. Préparer l’arrivée des “agents IA”

Un phénomène se dessine : les agents autonomes.

Ces programmes capables de naviguer sur le web pour collecter, comparer et agir, privilégient les sites bien structurés, documentés et cohérents.

Autrement dit, optimiser son site pour ces futurs robots, c’est anticiper le SEO de 2030.

6. Vers un web créé “par et pour” les IA ?

Un risque demeure : que le web devienne un écosystème fermé, où les IA se nourrissent de contenus déjà générés par d’autres IA. D’où l’importance, pour les éditeurs indépendants, de préserver une production originale et d’exiger la transparence sur les critères de sélection des IA.

7. 5 actions à engager dès maintenant

- Renforcer la signature humaine : auteurs identifiés, expertise affichée.

- Structurer ses pages : titres clairs, blocs courts, données structurées.

- Soigner les sources et citations pour être repris par les IA.

- Produire du contenu inédit : angles personnels, cas, retours d’expérience.

- Utiliser l’IA en appui, sans s’y reposer : mesure, contrôle, itération.

8. Le SEO devient un dialogue

Le référencement n’est plus une course aux mots-clés, mais un dialogue permanent entre l’humain et la machine. Les sites qui s’en sortent parlent à la fois à l’utilisateur et à l’intelligence artificielle, sans trahir l’un pour séduire l’autre.